Apple retrasa su polémico sistema de detección de imágenes de abusos infantiles

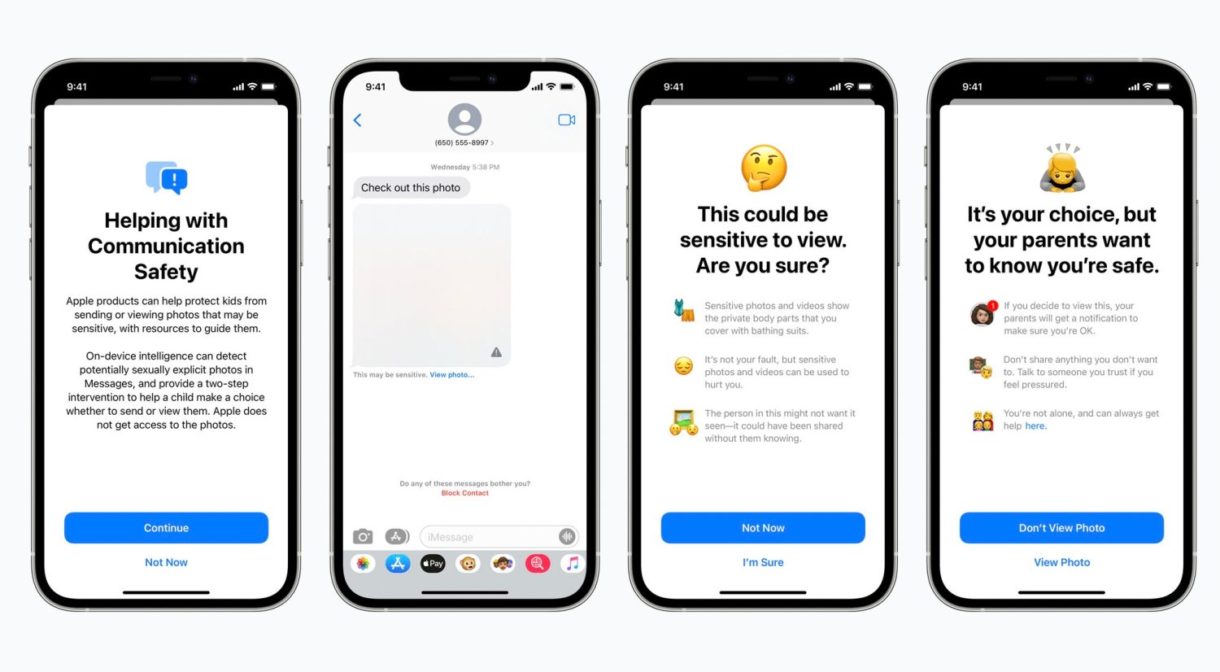

El pasado mes de Agosto, Apple anunciaba un plan para implantar tanto en iOS o iPadOS como en macOS un sistema de vigilancia para detectar imágenes de abusos infantiles, proteger a las posibles víctimas de los depredadores sexuales y limitar la difusión de este tipo de imágenes.

Como decíamos en anteriores artículos en los que tratábamos este tema, la idea era buena, pero quizás el modo de llevarla a cabo no lo era tanto y podía ser utilizada para otros medios muy alejados del propósito inicial de la compañía. Y no fuimos los únicos, ya que Apple ha decidido posponer por el momento la aplicación de esta herramienta. ¿Qué es lo que ha sucedido para acabar tomando esta decisión?

Desde la propia empresa comunican que han tomado esta decisión después de haber consultado con abogados especializados en la materia, desarrolladores y también tras escuchar las opiniones al respecto de la gente en general. Y es que a pesar de siempre se ha asegurado que las herramientas de detección se habían diseñado teniendo siempre en cuenta la privacidad del usuario, todo el mundo, desde especialistas en protección de datos, defensores de la privacidad digital a simples usuarios preocupados porque se pudiese acceder a los contenidos de su iPhone o su iPad,se le echaron encima enseguida.

Pero el problema radicaba no en el propósito, si no, como decíamos, en el método. Un algoritmo escanearía las fotos en busca de una huella digital que coincidiera con imágenes de abusos infantiles almacenadas e indexadas en una base de datos y si se detectaban indicios de sospecha sobre un determinado usuario, se supone que el propio sistema crearía una alerta para que un operario humano revisara las imágenes en cuestión y avisara a las autoridades si se diera el caso.

Esto, claro, suponía abrir la puerta a poder revisar el contenido de cualquier dispositivo y usar el sistema para propósitos maliciosos. Dicho riesgo, unido a que los pedófilos podrían librarse de ser investigados por el sistema simplemente evitando subir las imágenes a iCloud, ha llevado por fin a Apple a retrasar la aplicación de estas medidas, mientras investiga una forma mejor de hacer que funcionen.

Comentarios cerrados

Cómo transferir fotos de tu iPhone a tu PC Windows o Mac

Cómo transferir fotos de tu iPhone a tu PC Windows o Mac  iOS 17: Novedades, trucos y consejos para aprovechar al máximo tu dispositivo

iOS 17: Novedades, trucos y consejos para aprovechar al máximo tu dispositivo  La revolución del M2: Análisis detallado del nuevo chip de Apple

La revolución del M2: Análisis detallado del nuevo chip de Apple